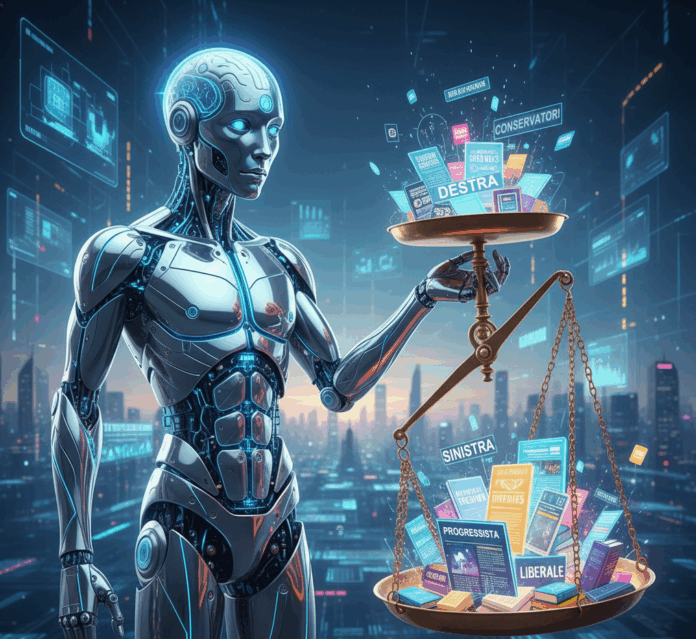

I modelli linguistici di grandi dimensioni, che noi chiamiamo genericamente Intelligenza Artificiale, tende a sovrastimare l’affidabilità delle fonti di orientamento politico di sinistra e a sottovalutare quelle di destra. Questo suggerisce che i modelli potrebbero ereditare pregiudizi dai dati di addestramento.

È uno degli aspetti interessanti che emerge dallo studio “Decoding AI Judgment: How LLMs Assess News Credibility and Bias” di Edoardo Loru, Jacopo Nudo, Niccolò Di Marco. Matteo Cinelli e Walter Quattrociocchi, tutti ricercatori della Sapienza Università di Roma, ha analizzato il comportamento di tre tra i più avanzati LLM: Gemini 1.5 Flash (Google), GPT-4o mini (OpenAI) e LLaMA 3.1 (Meta), confrontando le loro valutazioni con quelle di sistemi esperti di umani. Sebbene lo studio concluda che sostanzialmente le valutazioni umane e quelle non umane circa le fonti non affidabili si siano allineate (con una precisione tra l’85% e il 97%), rileva anche dei punti di debolezza nell’individuazione di quelle affidabili.

Ad esempio i modelli linguistici di grandi dimensioni, per le loro decisioni sulla credibilità di una notizia, si basano su specifici indicatori linguistici quali notizie locali e linguaggio neutro, penalizzando la comparsa di parole legate al sensazionalismo e alle controversie.

Tra le parole chiave a segnalare fonti non affidabili ci sono: “Trump, cospirazione, Biden, cure naturali, censura, deep state, big pharma”.

Ta quelle che indicano fonti affidabili troviamo: “cambiamento climatico, notizie, neutrale, diverso”. Tuttavia, quando non hanno accesso alla specifica notizia, ma solo al dominio, elaborano la loro valutazione in base a conoscenze pregresse e non mirate su quella pagina.

E poi c’è il fattore del pregiudizio dei dati di addestramento (che già emerge dalle parole chiave), non può essere casuale che tendano a sovrastimare l’affidabilità delle fonti che i modelli giudicano essere di orientamento politico di sinistra e a sottovalutare quelle ritenute di destra e questo ovviamente fa sospettare pesantemente un pregiudizio ereditato dai dati di addestramento, o meglio dai programmatori che li hanno immessi.