Il superamento della velocità della luce da parte di alcuni neutrini sparati dal CERN verso i laboratori sotto il Gran Sasso ha scosso alle fondamenta la comunità scientifica internazionale, una parte della quale parla ormai da tempo di fine della Relatività di Einstein. Ecco allora per voi lettori del nostro sito, un estratto dell'articolo scritto da Antonio Boncristiano e pubblicato su PuntoZero n. 2... per chi se l'era perso, per chi lo vuole rileggere, per chi non vede l'ora di entrare a far parte del mondo di PuntoZero…

La nonna di Einstein

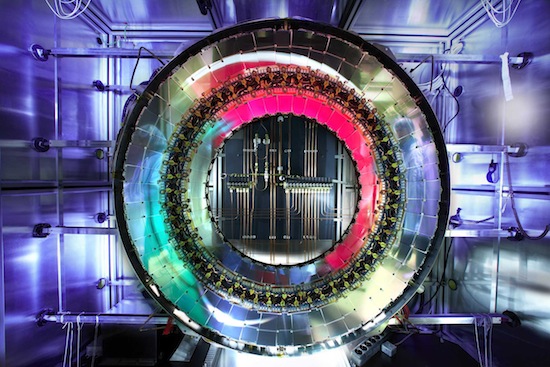

Il 23 settembre di quest’anno i quotidiani titolavano in modo sensazionalistico che la velocità della luce era stata superata sul filo di lana, da neutrini che andavano di fretta, di circa 60 nanosecondi. A comprovarlo sarebbero i dati accumulati in oltre tre anni dall'esperimento “Cern Neutrino to Gran Sasso”. Sciami di neutrini prodotti dall'acceleratore del Cern Super Proton Synchrotron, a Ginevra, venivano sparati per 730 km verso i Laboratori del Gran Sasso dell'Istituto Nazionale di Fisica Nucleare. L’analisi dei risultati indicherebbe che i neutrini anticipano di circa 60 miliardesimi di secondo rispetto alla velocità teorica, che dovrebbe risultare leggermente inferiore a quella della luce, “e non solo…” ma poiché tale velocità supererebbe di circa 6 km/s quella dei fotoni, appunto della luce, porrebbe in crisi il caposaldo più famoso della relatività e forse di tutta la fisica moderna, cioè che tale velocità, c, è una costante e non è superabile.

In conseguenza dell’annuncio si è scatenata la solita bagarre mediatica che intonava il de profundis alla relatività einsteiniana. Santoni vari si sono affrettati a ipotizzare l’alba di una nuova fisica, mentre il comune uomo della strada smarriva la penultima certezza che gli rimaneva (l’ultima è che non gli daranno mai la pensione). Ci si può legittimamente chiedere qual è il vero scenario. La risposta a tale domanda può essere data addentrandosi in formalismi di varia natura, spesso complessi, il che potrebbe indurre i miei lettori in stato di profonda depressione. Cerchiamo allora di inserire l’evento neutrinico nel suo alveo storico-scientifico ricorrendo solo a una buona conversazione informale fra amici e avendo ben presente che Albert Einstein asseriva che non si è mai capito bene qualcosa finché non si è in grado di spiegarlo alla propria nonna.

Di primo acchito c’è ovviamente da considerare che non si siano fatti errori sistematici (di cui non ci si accorge facilmente) oppure che non si siano considerati elementi di disturbo. La risposta sarà data ovviamente facendo ripetere l’esperimento da altri scienziati, in altri luoghi. L’impasse teorica che ha portato a mettere in discussione la relatività consiste nel fatto che nessuna particella materiale, cioè dotata di massa, può superare la velocità della luce nel vuoto. Purtroppo i neutrini hanno massa, per quanto minima, e una loro eventuale maggior velocità rispetto alla luce sembrerebbe invalidare l’impianto teorico relativistico, il quale però è confermato da dati incontrovertibili, che sono quelli cosmologici. Gli strumenti per uscire da questa incongruenza risiedono in una rivisitazione critica, che man mano introdurremo, di alcuni concetti.

Il primo: dato un fenomeno osservato, limitiamoci alla fisica, ne diamo una formulazione matematica che denominiamo “legge tal dei tali” e ci aspettiamo che il fenomeno si comporti obbedendo a tale “legge”. Tale assunto è del tutto errato. Il fenomeno si esplica con modalità proprie e la cosiddetta legge non è altro che la lente mentale, sotto forma di formulazione matematica, con la quale interpretiamo il fenomeno, il quale resta “in sé” una variabile indipendente (non analizziamo per ora il problema dell’interazione con l’osservatore) da una qualsivoglia nostra formulazione. Una qualsiasi di queste leggi è costruita sulla base dell’analisi di dati raccolti. Pertanto la qualità dei dati, determinata soprattutto dalla sensibilità e dall’affidabilità delle misure effettuate, influenza la formulazione della legge stessa. Il miglioramento delle misure ha portato alla scoperta di nuovi fenomeni e di nuove formulazioni più generali in cui la legge precedente va a rivestire il ruolo di caso particolare e non di teoria errata, come dire che mettiamo meglio a fuoco le nostre lenti, non che le buttiamo alle ortiche. Ovvero, in generale, le varie teorie che si susseguono diventano sempre più “aderenti” alla natura del fenomeno, nella misura in cui i dati sperimentali migliorano. È intuitivo che la maggiore sensibilità degli strumenti di misura porta ad evidenziare fenomeni difficilmente osservabili e che man mano ci conducono nel mondo dell’infinitamente piccolo. Così si è passati dallo studio degli atomi alla fisica delle particelle cui appartiene di diritto il neutrino, alla teoria delle stringhe. Ma il mondo dell’infinitamente piccolo, verrebbe da dire “come in basso così in alto”, è il costituente fondamentale dell’infinitamente grande e costituiva il “brodo primordiale” contenuto in una pallina cento miliardi di volte più piccola di un protone, che circa 14 miliardi di anni fa fece il grande botto. Le leggi dell’infinitamente grande e dell’infinitamente piccolo s’intrecciano strettamente, chiudono un cerchio, e per capire la realtà fisica ce ne occuperemo in modo inscindibile. All’altro capo del cerchio, in mezzo fra i due infiniti, gli esseri viventi: gli unici a percepire il “non sé”. Non si può non chiedersi il perché di tutto ciò. È la domanda di sempre, la ricerca del senso dell’esistenza. A chiederselo, professionalmente parlando, sono i fisici, i veri teologi del nostro tempo. E negli ultimi anni sono stati accumulati una serie di dati eclatanti che portano a scenari teorici che, se confermati da esperimenti di verifica, rivolterebbero realmente e completamente il senso dell’esistente, della vita, del divino, dando ben altro senso anche alla gara da cortile fra fotoni e neutrini. Accompagniamoli brevemente dunque, i novelli teologi, in questo viaggio.

“Io sono colui che è”. Questa è la definizione che Dio dà di sé stesso nella Bibbia. Ma ciò che è non è altro che ciò che esiste. Coincide con la definizione che Spinoza dà della divinità: Dio è immanente, è l’universo stesso. Lo stesso Einstein affermò che il suo era il Dio di Spinoza. Se e quando avremo capito l’universo forse avremo conosciuto Dio.

Affinché si possano porre teorie cosmologiche sensate, occorre una grande qualità dei dati osservativi. L’uso di telescopi e palloni sonda al di fuori dell’atmosfera e il netto miglioramento degli strumenti a terra ha consentito di allargare il range d’indagine sulle radiazioni cosmiche. Poiché la luce più lontana arriva dal passato più remoto, gli strumenti attuali ci consentono di risalire a 12 miliardi di anni fa, circa i quattro quinti del percorso che ci separa dal big bang. E dai confini osservabili, arriva un dato eclatante: anziché rallentare a causa dell’attrazione gravitazionale, l’universo sta accelerando. La deduzione nasce dallo studio delle esplosioni di supernove. Il calcolo dell’effetto Doppler dei relativi spettri luminosi, osservabili dai nostri strumenti, mostra che le supernove più lontane lo sono più di quanto previsto. Il che porta a concludere che è in atto un’accelerazione dell’espansione. A confermarlo è anche lo studio della radiazione cosmica di fondo, la traccia residua dell’esplosione del big bang, che peraltro rappresenta la maggior miniera informativa cui possiamo attingere. Dalle sue caratteristiche è possibile calcolare, per qualsiasi volume di spazio, quanta materia ed energia debba in media contenere. Per giustificare l’accelerazione dell’espansione occorre che sia presente in ciascun volume, una forma di energia sinora sconosciuta, l’energia oscura (Lord Fener ne sarebbe felice). Tale energia era già stata introdotta da Einstein all’interno della relatività con il nome di costante cosmologica, come approfondiremo. Intanto, se lo scenario è questo, il destino finale dell’universo è una rarefazione infinita di tutta la materia e dell’energia sino al nulla totale, con buona pace di qualsiasi forma di divinità immanente. Tali deduzioni provengono, però, dall’applicazione ai fenomeni osservati della teoria del big bang. Da dove origina? Quali sono i suoi limiti?

La radiazione cosmica di fondo

Intorno agli anni ‘60 del secolo scorso si congetturavano due teorie sulla genesi dell’universo. In ambedue era prevista l’espansione. La prima, denominata dello stato stazionario, non prevedeva un inizio del tempo e dello spazio, pertanto l’universo era esistente da sempre e la rarefazione della materia, dovuta al moto di espansione, era compensata dalla creazione di nuova materia. L’altra, partiva dall’osservazione fatta da Hubble negli anni ‘30 che le galassie si allontanano fra loro e che quelle più distanti lo fanno più rapidamente. Invertendo il processo, si consideravano un tempo e uno spazio iniziali in cui tutta la materia era contenuta in una singolarità a densità e temperatura inimmaginabili contenente solo radiazioni e particelle elementari. Tale singolarità aveva un diametro di circa 10-26 m e, ad una riunione di condominio, i suoi inquilini decisero di andarsene per i fatti propri, cioè di originare il Big Bang. Se spegnete la vostra pentola sul fornello, essa si raffredderà lentamente nel tempo, e dato che la temperatura del grande botto era un tantinello più alta, ancora oggi, se la teoria era corretta, si doveva trovare che l’universo era un po’ tiepidino. Nel 1965 A.A. Penzias e R.W. Wilson, che lavoravano per i Bell Laboratories, isolarono casualmente una radiazione a microonde di circa tre gradi kelvin che permeava isotropicamente tutto lo spazio, corrispondendo in pieno alle aspettative della teoria del Big Bang, che pertanto divenne il modello cosmologico di riferimento. La teoria si era costituita per opera di vari fisici nel corso di circa trent’anni, fra cui Gamow, Friedman e Lemaitre, a partire dalla teoria generale della relatività e dall’irradiazione del corpo nero, dovuta a Max Planck. Un corpo nero è qualsiasi oggetto in grado di assorbire le radiazioni incidenti e di ri-emetterle con una diversa distribuzione spettrale caratteristica dell’oggetto stesso. Anche la radiazione iniziale emessa dal Big Bang doveva avere l’impronta spettrale dell’oggetto che la conteneva, e tale impronta era stampata nella radiazione residua, teoricamente assestata sui cinque gradi kelvin e frequenza caratteristica delle microonde. In buona sostanza lo studio della radiazione e delle sue peculiarità, una volta identificata, unitamente ad altri dati disponibili, avrebbe consentito di dedurre le caratteristiche iniziali dell’universo. Un ulteriore dato fondamentale risiedeva nella constatazione che le stelle sono composte da idrogeno ed elio. L’idrogeno, un protone e un elettrone, avrebbe potuto formarsi facilmente. Per l’elio, due protoni e due neutroni, la storia è diversa. Far collassare i suoi costituenti in un nucleo poteva avvenire solo vincendo le forze repulsive fra protoni, il che permetteva di calcolare la temperatura e la pressione necessarie per tale trasformazione per i miliardi di stelle osservabili. Tale condizione era presente all’interno delle stelle, ma non era sufficiente a giustificare l’abbondanza di elio osservata (anche al di fuori delle stelle) il che portava direttamente all’ipotesi di un singolo evento primigenio avvenuto all’esterno delle stelle, anzi prima della formazione delle stelle stesse all’interno di un gas di neutroni a grandissima densità e temperatura. Storicamente il modello iniziale non riusciva ancora a teorizzare la nascita degli elementi più pesanti, ipotesi che invece era presente nella teoria dello stato stazionario; poi portava ad una stima errata sull’età dell’universo, di circa due miliardi di anni, in contrasto con datazioni geologiche della stessa Terra. D’altronde l’ipotesi di stato stazionario non prevedeva, ovviamente, l’esistenza di una radiazione di fondo, e considerava una temperatura del vuoto nulla. Le due ipotesi si fronteggiarono per decenni, con una buona prevalenza per lo stato stazionario, e fu solo l’identificazione e la successiva mappatura della radiazione di fondo che diede la svolta verso la moderna cosmologia, provvista di solide basi sperimentali.

Intorno agli anni ‘60 del secolo scorso si congetturavano due teorie sulla genesi dell’universo. In ambedue era prevista l’espansione. La prima, denominata dello stato stazionario, non prevedeva un inizio del tempo e dello spazio, pertanto l’universo era esistente da sempre e la rarefazione della materia, dovuta al moto di espansione, era compensata dalla creazione di nuova materia. L’altra, partiva dall’osservazione fatta da Hubble negli anni ‘30 che le galassie si allontanano fra loro e che quelle più distanti lo fanno più rapidamente. Invertendo il processo, si consideravano un tempo e uno spazio iniziali in cui tutta la materia era contenuta in una singolarità a densità e temperatura inimmaginabili contenente solo radiazioni e particelle elementari. Tale singolarità aveva un diametro di circa 10-26 m e, ad una riunione di condominio, i suoi inquilini decisero di andarsene per i fatti propri, cioè di originare il Big Bang. Se spegnete la vostra pentola sul fornello, essa si raffredderà lentamente nel tempo, e dato che la temperatura del grande botto era un tantinello più alta, ancora oggi, se la teoria era corretta, si doveva trovare che l’universo era un po’ tiepidino. Nel 1965 A.A. Penzias e R.W. Wilson, che lavoravano per i Bell Laboratories, isolarono casualmente una radiazione a microonde di circa tre gradi kelvin che permeava isotropicamente tutto lo spazio, corrispondendo in pieno alle aspettative della teoria del Big Bang, che pertanto divenne il modello cosmologico di riferimento. La teoria si era costituita per opera di vari fisici nel corso di circa trent’anni, fra cui Gamow, Friedman e Lemaitre, a partire dalla teoria generale della relatività e dall’irradiazione del corpo nero, dovuta a Max Planck. Un corpo nero è qualsiasi oggetto in grado di assorbire le radiazioni incidenti e di ri-emetterle con una diversa distribuzione spettrale caratteristica dell’oggetto stesso. Anche la radiazione iniziale emessa dal Big Bang doveva avere l’impronta spettrale dell’oggetto che la conteneva, e tale impronta era stampata nella radiazione residua, teoricamente assestata sui cinque gradi kelvin e frequenza caratteristica delle microonde. In buona sostanza lo studio della radiazione e delle sue peculiarità, una volta identificata, unitamente ad altri dati disponibili, avrebbe consentito di dedurre le caratteristiche iniziali dell’universo. Un ulteriore dato fondamentale risiedeva nella constatazione che le stelle sono composte da idrogeno ed elio. L’idrogeno, un protone e un elettrone, avrebbe potuto formarsi facilmente. Per l’elio, due protoni e due neutroni, la storia è diversa. Far collassare i suoi costituenti in un nucleo poteva avvenire solo vincendo le forze repulsive fra protoni, il che permetteva di calcolare la temperatura e la pressione necessarie per tale trasformazione per i miliardi di stelle osservabili. Tale condizione era presente all’interno delle stelle, ma non era sufficiente a giustificare l’abbondanza di elio osservata (anche al di fuori delle stelle) il che portava direttamente all’ipotesi di un singolo evento primigenio avvenuto all’esterno delle stelle, anzi prima della formazione delle stelle stesse all’interno di un gas di neutroni a grandissima densità e temperatura. Storicamente il modello iniziale non riusciva ancora a teorizzare la nascita degli elementi più pesanti, ipotesi che invece era presente nella teoria dello stato stazionario; poi portava ad una stima errata sull’età dell’universo, di circa due miliardi di anni, in contrasto con datazioni geologiche della stessa Terra. D’altronde l’ipotesi di stato stazionario non prevedeva, ovviamente, l’esistenza di una radiazione di fondo, e considerava una temperatura del vuoto nulla. Le due ipotesi si fronteggiarono per decenni, con una buona prevalenza per lo stato stazionario, e fu solo l’identificazione e la successiva mappatura della radiazione di fondo che diede la svolta verso la moderna cosmologia, provvista di solide basi sperimentali.

Stelle, galassie e ammassi

Dagli anni ‘70 fino ad oggi gli astronomi hanno avuto tempo di mappare il cosmo. Ed è nel sapere corrente che l’universo presenta un ordine strutturale. Non vi è una distribuzione casuale delle stelle, ma queste si raggruppano in strutture spesso spiraliformi e discoidali composte da centinaia di miliardi di stelle, dette galassie, l’insieme delle quali è dell’ordine di decine di miliardi. Un po’ meno noto è che anche buona parte delle galassie, circa il 10%, si raggruppano a gruppi di un migliaio circa, dette ammassi, occupando le regioni del cosmo con una struttura a “macchia di leopardo”. Sin qui l’accordo con la teoria del Big Bang e con la relatività generale resta buono. Un assunto della relatività, il cosiddetto principio cosmologico, prevede un’isotropia e un’omogeneità media dell’universo a scale medio grandi, laddove le galassie possono essere considerate delle mere fluttuazioni di densità. Se a scale maggiori si rilevassero strutture più complesse e non omogenee avremmo dei dati non in accordo con il principio cosmologico, che sarebbe da modificare. Tali super strutture esistono e sono state trovate, come pure enormi lacune con il vuoto pressoché totale che si estendono per milioni e milioni di anni luce. La topografia macroscopica dell’universo risulta simile ad un pane lievitato con enormi buchi vuoti, attorno ai quali si dispongono galassie ed ammassi come lunghi filamenti che si estendono per milioni di anni luce. L’origine di tali strutture deriva dalle condizioni iniziali del cosmo: prima del big bang le variabili della “pallina” erano densità e temperatura, forzatamente omogenee. Anche l’universo, poco dopo la sua nascita, era omogeneo, salvo lievi fluttuazioni (una parte su centomila) di densità. Nelle zone a maggior densità l’attrazione gravitazionale era maggiore e in grado di attirare materia dalle zone meno dense, sino a che col passare degli eoni si formarono i vuoti e i superammassi. La domanda è se tali strutture possono o meno essere definite omogenee, in accordo con il principio cosmologico. Mentre cercavano risposta a tale domanda, che peraltro fu positiva (il principio cosmologico resta valido), i cosmologi s’imbatterono in un dato a dir poco rivoluzionario. Stelle, gas, ammassi e tutto l’osservabile non rappresentavano che il due per cento della materia totale. E il resto? Il resto, rilevabile solo per i suoi effetti gravitazionali, è stato definito materia oscura. Una delle prime certezze sulla materia oscura è che essa segue la stessa distribuzione strutturale della materia ordinaria. Tuttavia la materia è solo una delle due componenti l’universo. L’altra componente, sotto forma di radiazioni, è l’energia. Ma anche per l’energia salta fuori una componente inattesa, l’energia oscura. Di essa parleremo più avanti perché è in stretta relazione con l’espansione dell’universo di cui ora ci occupiamo.

Esperimento Opera, per lo studio delle oscillazioni dei neutrini presso i laboratori del Gran Sasso. Credit: Opera/CERN

Su e giù per le calli

La colla dell’universo, dal sassolino agli ammassi galattici, è la forza di gravità. In contrasto con le altre forze fondamentali, che hanno natura sia attrattiva che repulsiva, la forza di gravità sembra avere solo natura attrattiva. Fu solo Einstein, nella relatività generale, ad introdurre parametri che, in date condizioni, consentono alla stessa gravità sperimentata da noi come attrattiva di avere effetti repulsivi. Di fatto tali condizioni non erano ritenute operanti nell’universo osservabile, anzi si riteneva che, esaurita la spinta del big bang, gradatamente la gravità dovesse prendere il sopravvento, rallentare l’espansione e, miliardi di anni dopo, ricollassare l’universo implodendolo di nuovo in una singolarità, da cui sarebbe riemerso un nuovo big bang, in un’eterna altalena. Invece pochi anni fa, nel 1998, lo studio delle esplosioni delle supernove più lontane ha permesso di stabilire che la loro velocità di espansione è maggiore di quella delle supernove più vicine. In una parola: in periferia l’espansione dell’universo sta accelerando, dato talmente rivoluzionario che fu inizialmente rifiutato dagli astronomi, i quali dovettero successivamente soccombere all’evidenza dei dati. Le ipotesi sono due. O tale accelerazione è sempre stata presente, oppure è iniziata in tempi relativamente recenti, circa cinque miliardi di anni fa. I due scenari conseguenti sono del tutto diversi. Nel primo caso ci siamo crogiolati con una teoria fasulla, da rivedere. Nel secondo si avrebbe una traccia importante per prevedere il destino finale del creato.

State correndo in autostrada ai confini dell’universo, un’autostrada che dei velocissimi operai (giapponesi suppongo…) vi costruiscono davanti. Nella teoria attuale la vostra auto non ha motore, ma è stata fiondata quindici miliardi di anni fa in quest’autostrada (senza neanche un autogrill…), e la sua velocità è determinata da due fattori in contrasto: la diminuzione di densità della materia, poiché si distribuisce su un volume man mano più ampio, che vi fa andare più veloci, e l’attrazione gravitazionale che vi rallenta. Il risultato è un tiro alla fune in cui l’esito finale dipende dalla quantificazione della massa gravitazionale, ma che in soldoni corrisponde ad una decelerazione più o meno veloce. E invece ora si scopre che la vostra auto ha un motore, l’energia oscura, e che sta accelerando, per cui il tiro alla fune si trasferisce fra l’insieme delle spinte attrattive gravitazionali contro quelle repulsive dovute all’energia oscura. Tuttavia per molto tempo tale motore deve essere stato spento, altrimenti, conti alla mano, l’attrazione gravitazionale non avrebbe avuto la forza sufficiente per aggregare pianeti, stelle, galassie e i vari ben di Dio di cui disponiamo. Anzi, se fosse stata operante già al primo stadio del big bang, non si sarebbero formati neanche idrogeno ed elio. Sulla base dello studio delle velocità relative delle supernove in funzione della loro anzianità (in particolare con l’uso dell’ Advanced Camera for Surveys montata nello spazio sul telescopio Hubble), si è rilevato che sino a circa cinque miliardi di anni fa l’universo era in fase di decelerazione, per cui il vostro motore è stato acceso più o meno in quel periodo.

Einstein, fra le due ipotesi di universo in accelerazione e quello in collasso, preferì rimanere nel mezzo e ipotizzare un universo statico alla fine dell’espansione dovuta al big bang. Serviva dunque una forza o, meglio, un effetto repulsivo in grado di annullare le attrazioni gravitazionali. Il calcolo pratico lo portò a determinare il valore di un fattore di bilanciamento (cui diede il nome di costante cosmologica, ma che molti fisici oggi chiamano energia del vuoto) la cui densità doveva essere circa la metà di quella della materia. Noi oggi invece osserviamo un’accelerazione per giustificare la quale occorrerebbe un valore della costante, cioè dell’energia del vuoto, pari almeno al doppio della densità della materia. Ovvero abbiamo teorizzato solo un quarto di tale energia e dobbiamo risalire all’origine degli altri tre quarti. Qui dobbiamo fare un salto nell’infinitamente piccolo, giacché la risposta potrebbe celarsi lì. La meccanica quantistica descrive inoppugnabilmente il funzionamento della materia dal livello atomico ai piani inferiori. L’assunto base della meccanica, il principio di indeterminazione di Heisenberg, porta a definire il vuoto più o meno come la porta dello Star Gate dell’omonimo film. Attraversate la porta e vi trovate istantaneamente in un altro universo, ma intanto nel vostro non esistete più, anche se complessivamente voi sapete sempre di essere vivi. Analogamente i nostri tre quarti di energia potrebbero probabilisticamente comparire dal nulla e rientrarvi secondo i dettami quantistici (cosa che mandava in bestia il buon Albert che ebbe a dire a Heisenberg che Dio non giocava ai dadi).

Purtroppo quando i fisici andarono a calcolare la densità di energia quantistica del vuoto, riscontrarono che questa assumeva un valore incredibilmente alto, sufficiente per alimentare miliardi di miliardi di universi. E poiché aveva un carattere repulsivo, né il nostro né qualunque altro universo sarebbe mai potuto esistere non potendosi aggregare la materia. L’accelerazione del nostro universo deve avere altra origine, vale a dire che l’energia del vuoto non ha origini quantistiche. Le ipotesi conseguenti divisero i fisici al pari dei nostri parlamentari. Alcuni asserivano che la relatività è sbagliata, altri che l’energia del vuoto cresce nel tempo, altri ancora che decresce, altri infine che non ci siamo accorti di un’altra forma di energia, oltre a quelle nucleari, elettromagnetiche e gravitazionali, che andrebbe sotto il nome di “quintessenza”. Lo studio delle supernove ci dice se queste ipotesi sono plausibili, poiché tutte queste teorie portano a momenti differenti per l’inizio dell’accelerazione, o momento di transizione. Al momento l’unica certezza è che le variazioni di densità dell’energia del vuoto che hanno portato all’accelerazione sono state minime. Sino a che non avremo altri dati sull’energia oscura, gli esiti possibili del suo tiro alla fune con la gravità spaziano da una super-accelerazione dell’universo (sino allo smembramento anche dei nuclei atomici) o, all’opposto, a un collasso finale. Intanto che scopriamo che potenza ha il nostro motore, cerchiamo di capirne alcune caratteristiche dal rombo che emette, dalla sua “musica”. E, come ora vedremo, la musica c’entra in pieno, in quanto la radiazione di fondo segue regole musicali.

Continua a leggere l'articolo di Antonio Boncristiano su PuntoZero n.2… e già che ci sei, non perdere l'ultimo numero di PuntoZero, in edicola, in libreria e nel nostro shop. Buona lettura! Verso l'Infinito….

L'autore. Antonio Boncristiano è titolare di metrologia legale e di tecnologia strumentale in ambito di fede pubblica. Già docente di matematica, fisica e chimica nelle scuole superiori, ha collaborato con aziende multinazionali nel campo della strumentazione medica, nei settori chirurgici, endoscopici, oculistici e laser. Opera da oltre un trentennio in qualità di ricercatore indipendente in vari ambiti scientifici, storici, antopologici. Collabora come articolista e revisore editoriale con Nexus Edizioni.