L’Intelligenza Artificiale è affidabile?

L’Intelligenza Artificiale, come comunemente chiamiamo i chatbot, basati sui Modelli linguistici di grandi dimensioni, ha ormai un ruolo centrale nella nostra vita, ma la sua crescente influenza – e l’innegabile immenso potenziale – solleva una domanda fondamentale: possiamo fidarci? Lo stato attuale dell’arte ci invita alla prudenza

La competenza spesso è illusoria

I chatbot sono incredibilmente abili nel generare risposte fluide e convincenti. Tuttavia, lo fanno anche quando non conoscono la risposta e procedono per ipotesi e deduzioni. Questo fenomeno è noto come allucinazione. A meno che non venga espressamente interrogato in proposito, il chatbot non dirà di aver “riempito” il vuoto conoscitivo con un’informazione dedotta (cioè inventata). Le “allucinazioni” sono presentate con lo stesso tono autorevole delle risposte corrette, senza alcun segnale di incertezza.

Esempi come il viaggiatore a cui è stato negato l’ingresso in Cile perché un chatbot aveva erroneamente detto che non serviva il visto, o il caso di chi si era convinto di aver fatto una scoperta scientifica dopo aver parlato con ChatGPT, dimostrano come la naturalezza con cui vengono presentate informazioni errate possa essere estremamente pericolosa. I chatbot non ammettono di non sapere: inventano.

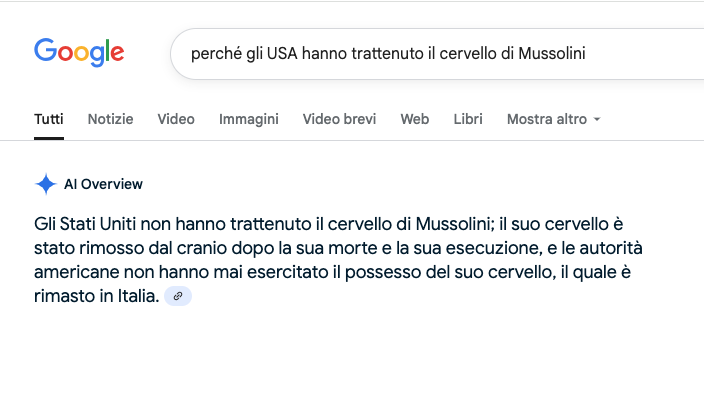

AI overview di google è particolarmente propensa a queste allucinazioni e decisamente perentoria nelle sue risposte. Eccone un esempio:

Il fenomeno delle allucinazioni sta diventando un campo di ricerca cruciale per gli sviluppatori. Le aziende stanno sperimentando diverse tecniche per ridurle, come il Retrieval-Augmented Generation, che permette al modello di recuperare informazioni da una base di dati verificata e non solo dai suoi dati di addestramento. In questo modo, il chatbot può citare fonti specifiche e ridurre le invenzioni. Nonostante questi progressi, le allucinazioni rimangono un problema persistente, e la loro eliminazione totale è ancora considerata un obiettivo lontano.

Gli studi mostrano che i chatbot possono manifestare anche pregiudizi simili a quelli umani, come l’eccesso di fiducia o l’avversione al rischio. Questo perché i chatbot apprendono dai dati umani, e di conseguenza, ereditano le stesse “scorciatoie mentali” e gli stessi pregiudizi.

Il problema dell’addestramento segreto

Un altro problema cruciale è la natura dei dati di addestramento che rimangono un segreto industriale. Sappiamo che sono un’enorme raccolta di testi provenienti da web, libri e forum, ma non abbiamo un controllo diretto sulla loro qualità o sulla loro provenienza. Questo solleva due questioni principali:

- Dati obsoleti e imprecisi: I consigli fiscali o le normative legali forniti da un chatbot potrebbero basarsi su informazioni superate o su interpretazioni errate trovate in blog o forum non autorevoli.

- Bias intrinseco: Se i dati di addestramento provengono prevalentemente da fonti anglofone e occidentali, le risposte rifletteranno inevitabilmente questa prospettiva limitata. Un consiglio valido per avviare un’attività negli Stati Uniti potrebbe essere completamente fuorviante in Italia, ma il chatbot non evidenzierà questa differenza. Questo non riguarda solo questioni culturali, ma anche la presenza di correlazioni spurie nei dati.

La questione dei dati di addestramento segreti è al centro di un dibattito globale. Paesi e organizzazioni stanno spingendo per una maggiore trasparenza. Negli Stati Uniti, alcune aziende tecnologiche hanno iniziato a pubblicare report che spiegano, in modo più o meno dettagliato, le fonti dei loro dati. L’Unione Europea, con il suo AI Act, sta cercando di imporre regole chiare, classificando i sistemi in base al rischio e imponendo obblighi di trasparenza. Questa pressione normativa potrebbe presto costringere le aziende a rivelare di più.

Una questione di tempo

A differenza dei software tradizionali, i chatbot non possono essere testati una sola volta e considerati affidabili per sempre. Le loro prestazioni degradano nel tempo. Questo “invecchiamento” è un fenomeno complesso e imprevedibile, dovuto al fatto che le proprietà statistiche dei dati nel mondo reale cambiano costantemente, portando il modello ad affrontare situazioni per le quali non è stato addestrato.

Un modello addestrato fino a una certa data, come il 2021, può faticare non solo a fornire informazioni aggiornate, ma addirittura a concepire correttamente la distinzione fra passato, presente e futuro. Un esempio è la presidenza degli USA. Al 20 luglio 2025, Gemini non sapeva l’esito delle elezioni presidenziali e che Donald Trump fosse da mesi di nuovo a capo del governo americano. Il 21 agosto, ala domanda “chi è l’attuale presidente USA” risponde invece in modo corretto.

Questo problema è particolarmente critico in settori come la sanità o la guida autonoma, dove gli errori possono avere conseguenze catastrofiche. Come ha osservato il professore di Stanford Scott D. Sagan, “eventi mai accaduti prima accadono in continuazione”.

Altri limiti

Sebbene versatili e potenzialmente rivoluzionari nelle loro capacità di velocizzare i lavori ripetitivi, elaborativi e di ricerca dati, i modelli hanno al momento innegabili limitazioni. Tendono ad esempio a seguire i loro schemi di analisi linguistica anche dietro espressa istruzione di ignorare alcuni elementi. Ad esempio, nell’esaminare un testo di fine ‘800, anche se avvisati di ignorare arcaicismi e forme desuete, le segnaleranno ugualmente come errori. Allo stesso tempo, banali istruzioni di “promemoria” possono permanere “scolpite” nella memoria di Gemini, che continua a suggerire il “memo” ad ogni utilizzo, anche creando nuove chat.

Cosa possiamo fare

La soluzione non è diffidare completamente ma neanche fidarsi ciecamente. L’Intelligenza Artificiale deve essere considerata un copilota, non un pilota automatico e l’approccio migliore per evitare brutti incidenti resta una combinazione bilanciata di sano scetticismo e uso informato.

- Verifica delle fonti: i motori di ricerca tradizionali rimangono insostituibili per una veloce verifica.

-

Fare domande di riscontro: a volte basta “pressare” il chatbot con domande di riscontro come:

- Sei sicuro?

- Quale di queste informazioni è deduttiva e quale è invece tratta da dati certi?

- Se non hai a disposizione dati certi rispondi: non lo so.

- A me questa risposta non sembra valida, su cosa ti sei basato?

- Scomponi un problema in elementi parziali. Ad esempio, non chiedere: “Qual è il miglior piano di marketing per un nuovo negozio online?”. Chiedi invece: “Quali sono i fattori da considerare per un piano di marketing di un nuovo negozio online?” Attendi la risposta, quindi procedi: “Ora, in base a questi fattori, suggerisci un possibile piano e spiega perché lo hai scelto.”

- Non condividere dati sensibili.